近期,大型语言模型(LLM)如ChatGPT等在处理与生成人类语言方面的能力显著增强,但它们在多大程度上模拟了人类大脑处理语言的神经过程,仍是未解之谜。然而,一项由哥伦比亚大学和费因斯坦医学研究所联合开展的研究,为这一谜题提供了新的线索。

据报道,研究团队深入探索了LLM与大脑神经反应之间的相似性。研究的主要推动者,论文第一作者加文・米施勒指出,他们的研究灵感源于LLM与神经AI领域的快速发展。米施勒在采访中透露,尽管早期的研究表明GPT-2的词嵌入与人脑对语言的神经反应存在某种程度的相似性,但GPT-2在当前人工智能领域已不再是领先者。

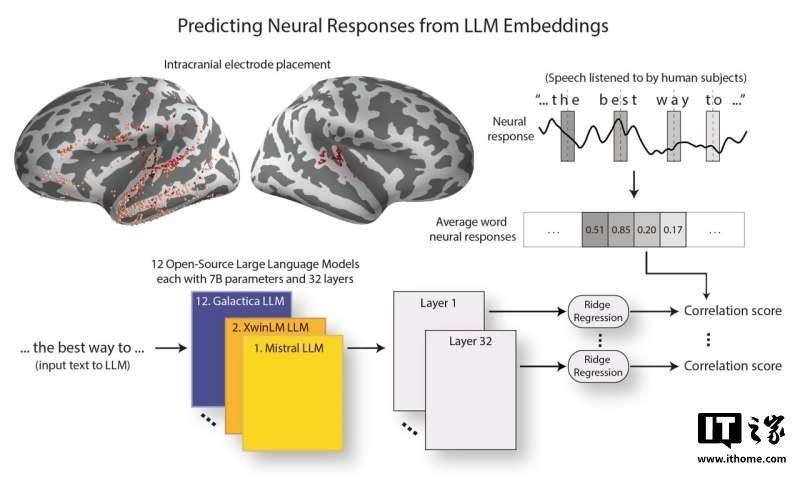

随着ChatGPT等更强大的模型的出现,关于这些新模型是否依然表现出与人类大脑相似的特征,米施勒及其团队展开了详细的探究。他们选择了12个在架构和参数数量上几乎一致的开源LLM进行分析,同时,通过神经外科患者脑部植入的电极,记录了他们听到语言时的大脑反应。

在研究中,米施勒团队将相同的演讲文本输入LLM,并提取其词嵌入,这些词嵌入是模型内部用于处理和编码文本的表示。为了衡量LLM与大脑的相似性,研究人员尝试通过预测大脑对词语反应的神经活动来评估两者的对应性。他们利用计算工具分析了LLM与大脑的对齐程度,特别关注了哪些层次的LLM与大脑中与语言处理相关的区域最为匹配。

米施勒表示,研究发现,随着LLM能力的提升,其词嵌入与大脑对语言的反应越来越接近。更令人惊讶的是,模型性能的提升与其与大脑层次结构的对齐程度提高之间存在关联。这意味着,在语言处理过程中,大脑不同区域提取的信息与性能较强的LLM的不同层次提取的信息更加一致。

这些研究结果表明,表现最好的LLM更能准确反映大脑的语言处理反应,并且这些模型的优秀表现可能与其早期层次的高效性密切相关。这一发现不仅揭示了LLM与人类大脑在语言处理方面的相似性,也为未来人工智能技术的发展提供了新的启示。